1. 초기 생애 및 교육

팀닛 게브루는 에티오피아에서 태어나 어린 시절 어려운 환경을 겪었으며, 15세에 미국으로 이민하여 인종차별을 경험하는 동시에 학업과 연구 경력을 시작했다.

1.1. 출생 및 배경

게브루는 1982년 또는 1983년에 에티오피아 아디스아바바에서 태어나 성장했다. 그녀의 부모는 모두 에리트레아 출신이며, 아버지는 전기 공학자이자 박사 학위를 소지하고 있었다. 그녀의 두 명의 언니 또한 전기 공학자였다. 게브루의 아버지는 그녀가 다섯 살 때 세상을 떠났고, 이후 그녀는 경제학자였던 어머니에 의해 양육되었다.

1.2. 이민 및 미국에서의 경험

게브루는 15세 때 에리트레아-에티오피아 전쟁이 한창이던 시기에 에티오피아를 떠나야 했다. 가족 중 일부가 에리트레아로 강제 추방되어 전쟁에 징집되는 상황을 겪은 후였다. 그녀는 처음에는 미국 비자 발급을 거부당해 잠시 아일랜드에서 생활하기도 했으나, 결국 미국에서 정치적 망명을 허가받았다. 그녀는 이 경험을 "비참했다"고 회고했다.

미국 매사추세츠주 서머빌에 정착하여 고등학교에 진학한 게브루는 곧바로 인종 차별을 경험하기 시작했다. 일부 교사들은 그녀가 우수한 성적을 보였음에도 불구하고 특정 고급 과정 수강을 불허하기도 했다. 이러한 경험은 그녀에게 기술 윤리에 대한 관심을 갖게 하는 결정적인 계기가 되었다. 고등학교 졸업 후, 경찰과의 한 사건은 게브루가 기술 윤리에 집중하게 되는 전환점이 되었다. 그녀의 흑인 친구가 술집에서 폭행을 당했고, 게브루는 이를 신고하기 위해 경찰을 불렀다. 하지만 경찰은 폭행 신고를 접수하는 대신 그녀의 친구를 체포하여 구금했다. 게브루는 이 사건을 "노골적인 체계적 인종차별의 사례"라고 언급하며, 이후 기술의 윤리적 측면에 대한 연구를 시작하게 되었다.

1.3. 학업 및 연구 경력 시작

2001년, 게브루는 스탠퍼드 대학교에 입학했다. 그녀는 스탠퍼드에서 전기 공학 학사 및 석사 학위를 취득했으며, 2017년에는 컴퓨터 비전 분야에서 박사 학위를 받았다. 박사 과정 동안 그녀는 페이페이 리 교수의 지도를 받았다.

스탠퍼드 재학 중이던 2004년, 게브루는 애플에서 인턴십을 시작하여 하드웨어 부서에서 오디오 부품용 회로를 설계하는 일을 했다. 이듬해에는 정규직 제안을 받아 오디오 엔지니어로 근무했다. 그녀의 상사는 그녀를 "두려움이 없는" 사람이라고 평가했으며, 동료들에게도 인기가 많았다. 애플 재직 중 게브루는 소프트웨어, 특히 사람의 형상을 감지할 수 있는 컴퓨터 비전 개발에 더 큰 관심을 갖게 되었다. 그녀는 또한 최초의 아이패드용 신호 처리 알고리즘을 개발하기도 했다. 당시 그녀는 자신의 작업이 감시에 사용될 가능성에 대해서는 고려하지 않았다고 말하며 "그저 기술적으로 흥미로웠을 뿐"이라고 언급했다.

2008년 미국 대통령 선거 기간 동안, 게브루는 버락 오바마를 지지하는 유세 활동에 참여했다.

2017년, 게브루는 LDV 캐피털 비전 서밋(LDV Capital Vision Summit) 대회에서 자신의 박사 연구를 발표했다. 이 대회는 컴퓨터 비전 과학자들이 자신의 연구를 산업계 및 벤처 투자가들에게 선보이는 자리였다. 게브루는 이 대회에서 우승하며 다른 기업가 및 투자자들과의 협력을 시작했다.

박사 과정 중이던 2016년과 졸업 후인 2018년에 게브루는 젤라니 넬슨의 프로그래밍 캠페인인 '아디스 코더(AddisCoder)'에 참여하기 위해 에티오피아를 다시 방문했다.

게브루는 박사 과정 중 AI의 미래에 대한 우려를 담은 논문을 작성했으나, 이 논문은 출판되지 않았다. 그녀는 이 논문에서 AI 분야의 다양성 부족이 가져올 위험성을 지적했으며, 자신의 경찰 관련 경험과 프로퍼블리카의 예측 경찰 활동 조사에서 드러난 기계 학습 내 인간의 편향 투영 문제를 중심으로 논의를 펼쳤다. 또한 그녀는 논문에서 "소년 클럽 문화"를 강하게 비판하며, 학회 모임에서 술에 취한 남성 참가자들로부터 겪었던 성희롱 경험을 언급하고, 해당 분야의 유명 인사들에 대한 영웅 숭배를 비판했다.

2. 경력 및 활동

2.1. 초기 경력 (애플, 마이크로소프트)

게브루는 스탠퍼드 대학교 재학 중이던 2004년 애플에 인턴으로 입사하여 하드웨어 부서에서 오디오 부품용 회로를 제작하는 일을 했다. 이듬해 정규직 제안을 받아 오디오 엔지니어로 근무했다. 그녀의 매니저는 그녀를 "두려움이 없다"고 평가했으며, 동료들에게도 인기가 많았다. 애플 재직 중 게브루는 소프트웨어, 특히 사람의 형상을 감지할 수 있는 컴퓨터 비전 개발에 더 큰 관심을 갖게 되었다. 그녀는 또한 최초의 아이패드용 신호 처리 알고리즘을 개발하기도 했다. 당시 그녀는 자신의 작업이 감시에 사용될 가능성에 대해서는 고려하지 않았다고 말하며 "그저 기술적으로 흥미로웠을 뿐"이라고 언급했다.

애플을 떠난 지 오랜 시간이 지난 2021년 여름, 애플 엔지니어 셰어 스칼렛이 게브루와 상의하여 이끈 AppleToo 운동 기간 동안, 게브루는 애플에서 "수많은 터무니없는 일들"을 겪었으며 "어떻게 그들이 언론의 주목을 피할 수 있었는지 항상 궁금했다"고 밝혔다. 그녀는 애플의 책임이 오랫동안 지연되어 왔으며, 더 이상 언론의 감시를 피할 수 없을 것이라고 경고했다. 게브루는 또한 언론이 애플과 다른 거대 기술 기업들을 다루는 방식에 대해 비판하며, 언론이 이러한 기업들을 대중의 감시로부터 보호하는 데 일조한다고 주장했다.

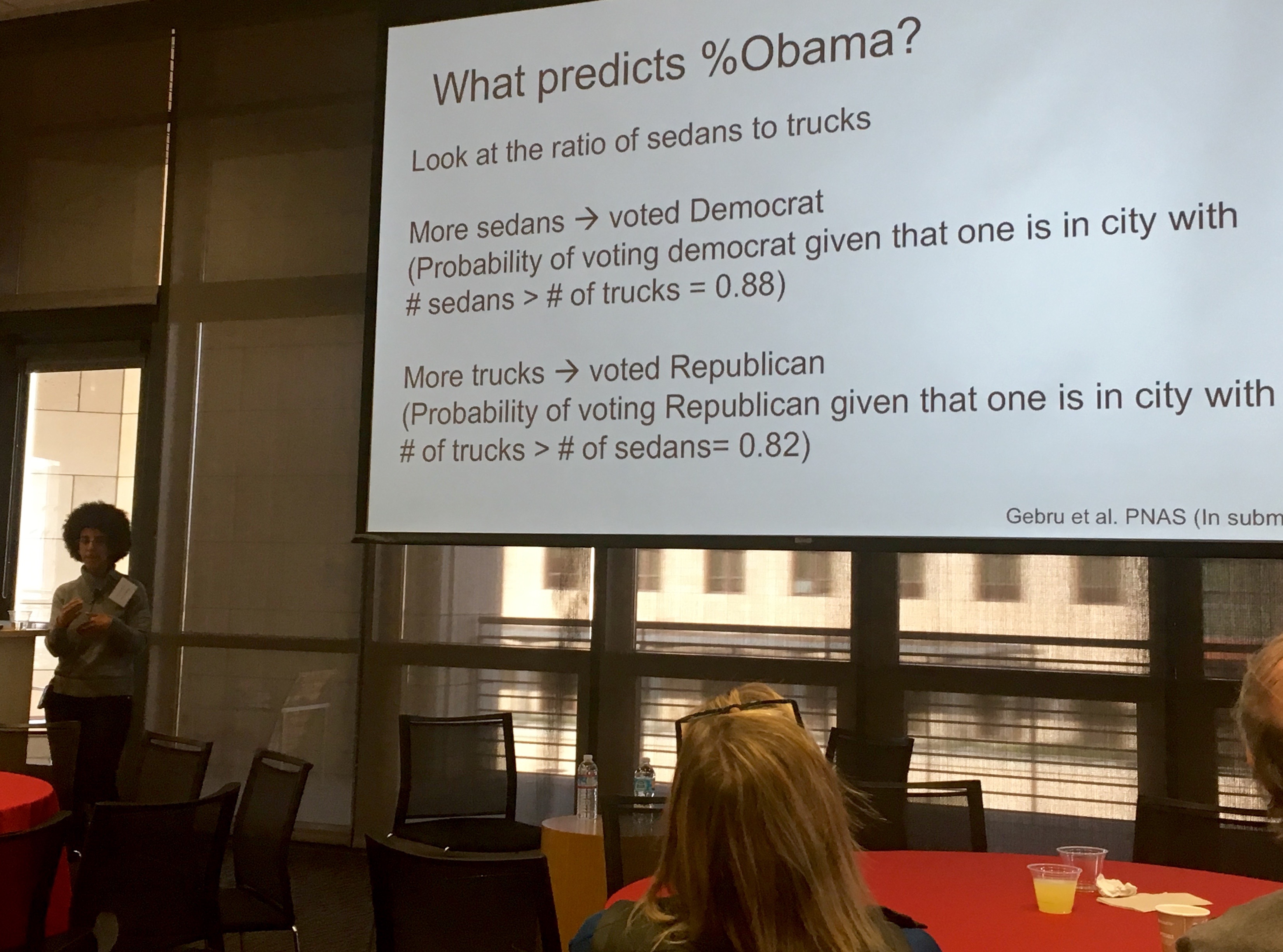

2013년, 게브루는 스탠퍼드 대학교의 페이페이 리 연구실에 합류했다. 그녀는 공개적으로 사용 가능한 이미지의 데이터 마이닝을 활용하는 연구를 진행했다. 그녀는 정부 및 비정부 기관들이 지역사회에 대한 정보를 수집하기 위해 사용하는 비용에 관심을 가졌다. 대안을 탐구하기 위해 게브루는 딥 러닝과 구글 스트리트 뷰를 결합하여 미국 지역의 인구 통계를 추정하는 연구를 수행했다. 이 연구는 투표 성향, 소득, 인종, 교육 수준과 같은 사회경제적 특성이 자동차 관찰을 통해 추론될 수 있음을 보여주었다. 예를 들어, 픽업 트럭의 수가 세단의 수보다 많으면 해당 지역사회는 미국 공화당에 투표할 가능성이 더 높다는 것을 발견했다. 그들은 미국에서 인구가 가장 많은 200개 도시의 1,500만 개 이상의 이미지를 분석했다. 이 연구는 BBC 뉴스, 뉴스위크, 이코노미스트, 뉴욕 타임스 등 여러 주요 언론에 광범위하게 보도되었다.

2015년, 게브루는 캐나다 몬트리올에서 열린 인공지능 분야의 최고 학술대회인 신경 정보 처리 시스템 학회(NIPS)에 참석했다. 3,700명의 참석자 중 그녀는 소수의 흑인 연구자 중 한 명이었다. 이듬해 다시 참석했을 때, 그녀는 8,500명의 참가자 중 흑인 남성은 5명뿐이었고, 자신은 유일한 흑인 여성이었음을 기록했다. 그녀는 동료 레디엣 아베베와 함께 인공지능 분야에서 활동하는 흑인 연구자들의 커뮤니티인 블랙 인 AI를 공동 설립했다. 블랙 인 AI는 인공지능 분야에서 흑인 전문가와 리더의 존재감, 가시성, 복지를 높여 해당 분야에 대한 접근성을 민주화하는 것을 목표로 한다.

2017년 여름, 게브루는 마이크로소프트에 박사 후 연구원으로 합류하여 공정성, 책임성, 투명성, 윤리 (AI) 연구소(FATE lab)에서 활동했다. 2017년 공정성 및 투명성 컨퍼런스에서 게브루는 MIT 테크놀로지 리뷰와의 인터뷰에서 AI 시스템에 존재하는 편향과 AI 팀의 다양성을 높이는 것이 이 문제를 어떻게 해결할 수 있는지에 대해 논의했다. 인터뷰에서 재키 스노우가 "다양성 부족이 인공지능, 특히 컴퓨터 비전을 어떻게 왜곡시키는가?"라고 질문하자, 게브루는 소프트웨어 개발자들에게 존재하는 편향을 지적했다. 마이크로소프트 재직 중 게브루는 조이 부올람위니와 함께 '젠더 셰이즈(Gender Shades)'라는 연구 논문을 공동 저술했다. 이 논문은 이후 매사추세츠 공과대학교의 더 광범위한 프로젝트의 이름이 되었으며, 상업용 안면 인식 시스템이 흑인 여성을 백인 남성보다 35% 적게 인식한다는 사실을 밝혀냈다.

2.2. 구글에서의 AI 윤리 연구

게브루는 2018년 구글에 입사하여 마가렛 미첼과 함께 인공지능 윤리 팀의 공동 리더를 맡았다. 그녀는 인공지능의 함의를 연구하며 기술이 사회적 선을 행하는 능력을 향상시키기 위해 노력했다.

2019년, 게브루는 다른 인공지능 연구자들과 함께 "아마존이 법 집행 기관에 안면 인식 기술을 판매하는 것을 중단할 것을 촉구하는 서한에 서명했다." 그녀는 MIT 연구원들이 수행한 연구를 인용하며 아마존의 안면 인식 시스템이 다른 기술 기업의 안면 인식 소프트웨어보다 피부색이 어두운 여성을 식별하는 데 더 어려움을 겪는다는 점을 지적했다. 뉴욕 타임스와의 인터뷰에서 게브루는 현재 안면 인식 기술이 법 집행 및 보안 목적으로 사용하기에는 너무 위험하다고 자신의 견해를 밝혔다.

2.3. '확률적 앵무새' 논문 및 구글 퇴사

2020년, 게브루는 5명의 공동 저자와 함께 "확률적 앵무새의 위험성: 언어 모델이 너무 커질 수 있는가?"라는 제목의 논문을 작성했다. 이 논문은 매우 큰 대규모 언어 모델(LLM)의 위험성을 분석했으며, 여기에는 환경 발자국, 재정적 비용, 대규모 모델의 불투명성, 특정 집단에 대한 편견을 드러낼 수 있는 LLM의 잠재력, LLM이 처리하는 언어를 이해하지 못하는 한계, 그리고 허위 정보 확산에 LLM이 사용될 가능성 등이 포함되었다.

2020년 12월, 구글 경영진이 그녀에게 해당 논문을 출판 전에 철회하거나 논문에 참여한 구글 직원들의 이름을 모두 삭제하라고 요구하면서 게브루의 구글 고용 관계는 종료되었다. 6명의 저자 중 에밀리 M. 벤더만이 당시 구글에 고용되어 있지 않았다. 게브루는 내부 협업 목록에 보낸 6페이지 분량의 이메일에서, 자신이 갑작스러운 회의에 소환되어 논문 철회 요청을 받았고, 이에 대해 해당 결정을 내린 모든 사람의 이름과 이유, 그리고 구글의 요구에 맞춰 논문을 수정하는 방법에 대한 조언을 요청했다고 설명했다. 그녀는 해당 정보가 제공되지 않으면 "마지막 근무일"에 대해 관리자와 논의하겠다고 밝혔다. 구글은 그녀의 요청을 받아들이지 않고 즉시 고용을 종료하며 그녀의 사직서를 수락했다고 발표했다. 그러나 게브루는 자신이 공식적으로 사직서를 제출한 적이 없으며, 단지 사직을 위협했을 뿐이라고 주장했다.

구글의 AI 연구 책임자인 제프 딘은 게브루의 논문이 환경 영향 및 모델 편향과 같은 문제들을 완화하기 위한 최근의 관련 연구들을 너무 많이 무시했기 때문에 이러한 결정을 내렸다는 내용의 이메일을 보냈다. 딘은 게브루의 퇴사에 대한 자신의 내부 이메일과 생각을 공개적으로 발표하며, "야심찬 문제에 책임감 있게 대처하기 위한" 구글의 연구 논문 검토 과정을 옹호했다. 게브루와 그녀의 지지자들은 이 초기 발표와 딘의 후속 침묵이 그녀를 향한 괴롭힘을 촉발하고 가능하게 했다고 비난했다. 게브루는 트위터에서 수많은 스톡 계정과 인터넷 트롤들로부터 인종차별적이고 음란한 내용의 지속적인 괴롭힘을 당했다. 게브루와 그녀의 지지자들은 일부 괴롭힘이 기계 학습 연구자인 페드로 도밍고스와 사업가 마이클 리삭으로부터 비롯되었다고 주장했다. 리삭은 그녀의 연구가 "과학으로 위장한 옹호"라고 말한 바 있다. 리삭은 또한 미첼과 벤더, 그리고 게브루의 이전 팀 동료들을 괴롭힌 것으로 알려졌다. 트위터는 2021년 2월 1일 리삭의 계정 접근을 일시적으로 중단했다.

게브루는 자신이 해고당했다고 거듭 주장했으며, 약 2,700명의 구글 직원과 4,300명 이상의 학계 및 시민사회 지지자들이 게브루의 해고를 규탄하는 서한에 서명했다. 9명의 미국 의회 의원들은 구글에 팀닛 게브루의 퇴사 상황을 명확히 해줄 것을 요청하는 서한을 보냈다. 게브루의 이전 팀은 부사장 메건 카콜리아를 팀의 관리 체인에서 해임할 것을 요구했다. 카콜리아는 게브루의 직속 매니저인 새미 벵기오에게 먼저 통보하지 않고 게브루를 해고한 것으로 알려졌으며, 게브루의 이전 팀은 카콜리아와 딘이 게브루에게 가한 처우에 대해 사과할 것을 요구했다. 미첼은 트위터를 통해 AI에서 편향과 유해성을 제거하기 위해 노력하는 직원들에 대한 구글의 처우, 특히 게브루의 해고에 대해 비판했다. 미첼은 이후 기밀 사업 관련 문서와 다른 직원들의 개인 정보를 무단으로 반출했다는 혐의로 해고되었다.

게브루의 퇴사 상황에 대한 부정적인 여론이 확산되자, 구글의 모회사인 알파벳의 최고경영자 순다르 피차이는 트위터를 통해 공개적으로 사과했으나, 게브루가 해고된 것인지 사임한 것인지는 명확히 밝히지 않았다. 그는 해당 사건에 대해 수개월간의 조사를 시작했다. 조사 결과 발표 후, 딘은 구글이 "특정 직원이 회사를 떠나는 방식에 대한 접근 방식을 변경할 것"이라고 발표했지만, 여전히 게브루의 퇴사가 자발적이었는지 여부는 명확히 하지 않았다. 또한 딘은 "민감한" 주제의 연구 논문 검토 방식이 변경될 것이며, 다양성, 형평성, 포용성(DEI) 목표가 분기별로 알파벳 이사회에 보고될 것이라고 말했다. 게브루는 트위터에 구글로부터 "더 이상 기대할 것이 없다"고 썼으며, 이러한 변화들이 자신이 해고된 이유가 된 요구 사항들 때문이었지만, 아무도 이에 대해 책임을 지지 않았다고 지적했다. 이 사건 이후 두 명의 구글 엔지니어가 회사에서 사임했다.

게브루의 퇴사 이후, 구글은 회사 내 인종차별 경험에 대해 논의하는 포럼을 개최했다. 직원들은 NBC 뉴스에 이 포럼의 절반 가량이 게브루의 발언을 불신하는 데 할애되었으며, 이는 회사가 그녀를 본보기로 삼으려 한다는 인상을 주었다고 보도했다. 이 포럼에 이어 구글의 흑인 직원들을 위한 집단 심리 치료 세션이 공인 치료사와 함께 진행되었는데, 직원들은 이 세션이 게브루의 해고로 인해 자신들이 느낀 상처를 무시하는 태도를 보였다고 말했다.

2.4. 분산 인공지능 연구소 (DAIR) 설립

2021년 6월, 게브루는 구글의 윤리적 AI 팀에서의 경험과 '블랙 인 AI'에서의 활동을 모델로 삼아 "독립적인 연구 기관을 설립하기 위한 자금을 모으고 있다"고 발표했다.

2021년 12월 2일, 그녀는 분산 인공지능 연구소(DAIR)를 공식 출범시켰다. 이 연구소는 아프리카와 미국 내 아프리카 이민자들을 중심으로 소외 계층에 대한 인공지능의 영향을 기록하는 데 중점을 둘 예정이다. DAIR의 초기 프로젝트 중 하나는 남아프리카 공화국의 타운십 위성 이미지를 AI로 분석하여 아파르트헤이트의 유산을 더 잘 이해하는 것을 목표로 한다.

게브루는 에밀 P. 토레스와 함께 TESCREAL이라는 신조어를 만들었다. 이는 트랜스휴머니즘, 익스트로피즘, 특이점주의, 러시아 우주론, 합리주의, 효율적 이타주의, 장기적 관점주의 등 중첩되는 미래주의 철학들을 비판하기 위한 약어이다. 게브루는 이러한 철학들이 거대 기술 기업에 우익적 영향을 미치고 있으며, 그 지지자들을 "인류에게 이롭다"고 포장하며 해로운 프로젝트를 생산했던 "20세기 우생학자들"에 비유했다. 게브루는 범용 인공지능(AGI) 연구가 우생학에 뿌리를 두고 있다고 비판하며, AGI 구축 시도는 본질적으로 안전하지 않은 행위이므로 AGI에 대한 초점을 다른 곳으로 돌려야 한다고 주장했다.

3. 주요 연구 분야 및 기여

3.1. 알고리즘 편향 및 공정성

팀닛 게브루는 AI 시스템 내에 존재하는 편향을 식별하고 이를 완화하기 위한 연구에 집중적으로 기여했다. 그녀는 자신의 박사 학위 논문에서 컴퓨터 비전 방법을 사용하여 사회경제적 특성을 추정하는 연구를 수행하며, 데이터에 내재된 편향이 어떻게 사회적 불평등을 반영하고 강화할 수 있는지를 보여주었다. 특히, 그녀는 프로퍼블리카의 예측 경찰 활동 조사에서 드러난 기계 학습 내 인간의 편향 투영 문제를 비판하며, AI 시스템이 기존의 사회적 편견을 답습하고 확대할 수 있음을 경고했다.

3.2. 안면 인식 기술 및 성별/인종 차별

게브루의 가장 영향력 있는 연구 중 하나는 조이 부올람위니와 공동으로 수행한 '젠더 셰이즈(Gender Shades)' 프로젝트이다. 이 연구는 상업용 안면 인식 시스템의 성별 및 인종별 정확도 차이를 밝혀냈다. 연구 결과, 특정 시스템이 흑인 여성을 백인 남성보다 35% 적게 인식하는 등 심각한 정확도 불균형을 보였다. 이 연구는 안면 인식 기술의 윤리적 문제를 공론화하고, 기술 개발 과정에서 다양성과 포용성이 왜 중요한지에 대한 인식을 높이는 데 결정적인 역할을 했다. 게브루는 이 연구를 바탕으로 안면 인식 기술이 현재로서는 법 집행 및 보안 목적으로 사용하기에는 너무 위험하다고 주장하며, 아마존과 같은 기업들이 해당 기술을 법 집행 기관에 판매하는 것을 중단할 것을 촉구하는 서한에 서명하기도 했다.

3.3. 대규모 언어 모델(LLM)의 위험성

게브루는 2020년 5명의 공동 저자와 함께 발표한 "확률적 앵무새의 위험성: 언어 모델이 너무 커질 수 있는가?" 논문을 통해 대규모 언어 모델(LLM)의 잠재적 위험성을 심층적으로 분석했다. 이 논문은 LLM의 방대한 규모로 인한 환경 발자국과 막대한 재정적 비용, 그리고 모델의 복잡성으로 인한 불투명성을 지적했다. 또한 LLM이 학습 데이터에 포함된 편향을 반영하여 특정 집단에 대한 편견을 드러내거나, 실제 언어를 이해하지 못하고 단지 통계적 패턴만을 학습한다는 점, 그리고 허위 정보 확산 등 악용될 가능성이 있음을 경고했다. 이 논문은 LLM의 윤리적 개발과 배포에 대한 중요한 논의를 촉발시켰다.

3.4. AI 윤리 및 사회적 영향

게브루는 AI 기술이 사회 전반, 특히 소외 계층에 미치는 윤리적, 사회적 영향을 탐구하고 개선 방안을 제시하는 데 주력했다. 그녀는 마이크로소프트의 공정성, 책임성, 투명성, 윤리 (AI) 연구소(FATE lab)에서 박사 후 연구원으로 활동하며 AI 시스템의 편향 문제를 연구했다. 구글에서도 윤리적 AI 팀을 공동으로 이끌면서 기술이 사회적 선을 행하는 능력을 향상시키는 방안을 모색했다. 그녀는 기술 개발 과정에서 다양성이 부족하면 AI 시스템에 개발자들의 편향이 투영될 수 있음을 강조하며, 기술 분야의 포용성 증진이 윤리적인 AI 개발의 필수 조건임을 역설했다.

4. 사회 운동 및 옹호 활동

4.1. Black in AI 공동 창립 및 활동

팀닛 게브루는 인공지능 분야의 흑인 연구자 커뮤니티인 블랙 인 AI를 레디엣 아베베와 함께 공동 설립했다. 그녀는 2015년과 2016년 신경 정보 처리 시스템 학회(NIPS)에 참석했을 때 흑인 연구자가 극히 드물다는 사실을 깨닫고 이러한 커뮤니티의 필요성을 절감했다. 2016년 NIPS에는 8,500명의 참가자 중 흑인 남성은 5명, 흑인 여성은 게브루 단 한 명뿐이었다. 블랙 인 AI는 인공지능 분야에서 흑인 전문가와 리더의 존재감, 가시성, 복지를 높여 해당 분야에 대한 접근성을 민주화하는 것을 목표로 한다. 2017년부터 블랙 인 AI는 매년 NIPS에서 워크숍을 개최하며 흑인 연구자들의 교류와 성장을 지원하고 있다.

4.2. 기술 분야의 다양성 및 포용성 증진

게브루는 과학, 기술, 공학, 수학(STEM) 분야, 특히 AI 연구에서 여성 및 소수 인종의 참여를 확대하기 위한 적극적인 옹호 활동을 펼쳤다. 그녀는 기술 업계의 "소년 클럽 문화"와 학회에서 겪었던 성희롱 경험을 공개적으로 비판하며, 이러한 문화가 다양성을 저해한다고 지적했다.

구글 퇴사 이후, 그녀의 해고는 기술 분야의 다양성 및 포용성 문제에 대한 광범위한 논의를 촉발시켰다. 네이선 커밍스 재단은 컬러 오브 체인지와 협력하여 알파벳의 "사회적 형평성 감사"를 요구하는 주주 제안을 제출했다. 이는 구글의 제품이 흑인, 원주민, 유색인종 커뮤니티에 미치는 "부정적인 영향"을 분석하고, 차별에 대한 우려를 제기한 소수 민족 직원들에게 구글이 보복했는지 여부를 조사할 것을 요청하는 내용이었다. 이 제안은 게브루의 해고, 그녀가 구글에 더 많은 유색인종 직원을 고용할 것을 촉구했던 점, 그리고 구글 기술 내 인종 기반 편향에 대한 그녀의 연구를 근거로 삼았다. 이 제안은 코리 부커가 이끄는 미국 민주당 상원 의원 그룹의 비공식적인 요청에 이은 것이었다.

2021년 12월, 로이터 통신은 캘리포니아 공정 고용 주택부가 구글의 흑인 여성 직원 처우에 대해 조사 중이라고 보도했다. 이는 현직 및 전직 직원들의 수많은 차별 및 괴롭힘 정식 고발에 따른 것이었다. 게브루와 다른 유색인종 직원들은 인종차별 및 성차별 경험을 인사 관리 부서에 보고했을 때, 회사 직원 지원 프로그램을 통해 병가 및 치료를 권유받았다고 보고했다. 게브루와 다른 이들은 자신의 해고가 보복성이며, 구글이 "제도적으로 인종차별적"이라는 증거라고 믿고 있다. 구글은 "이 중요한 작업에 계속 집중하고 있으며, 구글이 대표성을 갖고 공정하도록 모든 우려 사항을 철저히 조사하고 있다"고 밝혔다.

4.3. TESCREAL 비판 및 기술 윤리 비판

게브루는 에밀 P. 토레스와 함께 TESCREAL이라는 신조어를 만들어 트랜스휴머니즘, 익스트로피즘, 특이점주의, 러시아 우주론, 합리주의, 효율적 이타주의, 장기적 관점주의 등 중첩되는 미래주의 철학들을 비판했다. 게브루는 이러한 철학들이 거대 기술 기업에 우익적 영향을 미치고 있다고 보며, 그 지지자들을 "인류에게 이롭다"고 포장하며 해로운 프로젝트를 생산했던 "20세기 우생학자들"에 비유했다. 게브루는 범용 인공지능(AGI) 연구가 우생학에 뿌리를 두고 있다고 비판하며, AGI 구축 시도는 본질적으로 안전하지 않은 행위이므로 AGI에 대한 초점을 다른 곳으로 돌려야 한다고 주장했다. 그녀는 "누구를 위한 유토피아인가?"라는 질문을 던지며 AGI의 잠재적 위험에 대한 우려를 표명했다.

5. 수상 및 인정

팀닛 게브루는 그녀의 학문적, 사회적 기여를 인정받아 다음과 같은 주요 상과 명예를 얻었다.

- 2019년: 조이 부올람위니 및 이놀루와 데보라 라지와 함께 벤처비트의 'AI 이노베이션 어워드' 중 'AI 포 굿(AI for Good)' 부문을 수상했다. 이는 안면 인식의 알고리즘 편향이라는 중요한 문제를 조명한 그들의 연구를 인정받은 것이다.

- 2021년: 포춘 (잡지)이 선정한 '세계에서 가장 위대한 리더 50인' 중 한 명으로 선정되었다.

- 2021년: 과학 저널 네이처 (저널)가 선정한 '2021년 과학 발전에 중요한 역할을 한 10인' 명단에 포함되었다.

- 2022년: 타임 (잡지)이 선정한 '2022년 가장 영향력 있는 인물 100인' 중 한 명으로 선정되었다.

- 2023년: 카네기 재단의 '위대한 이민자상' 수상자로 선정되었다. 이는 윤리적 인공지능 분야에 대한 그녀의 중요한 기여를 인정받은 것이다.

- 2023년 11월: BBC의 'BBC 100인 여성' 명단에 이름을 올리며 세계에서 가장 영감을 주고 영향력 있는 여성 중 한 명으로 인정받았다.

6. 영향력 및 유산

팀닛 게브루는 인공지능 윤리 담론, 기술 산업의 관행, 그리고 과학, 기술, 공학, 수학(STEM) 분야의 소외 계층에 지대한 영향을 미쳤다. 그녀의 연구는 AI 시스템에 내재된 알고리즘 편향의 존재를 명확히 밝혀내고, 특히 안면 인식 기술과 대규모 언어 모델이 사회에 미칠 수 있는 부정적인 영향을 경고하며 기술 개발의 사회적 책임에 대한 인식을 크게 높였다.

구글에서의 퇴사 사건은 단순한 개인의 이직을 넘어, 거대 기술 기업 내부의 다양성, 표현의 자유, 연구 윤리 문제를 공론화하는 계기가 되었다. 이 사건은 수많은 기술 업계 종사자들과 학계, 시민 사회의 지지를 이끌어냈으며, 기업들이 AI 윤리 문제를 더욱 진지하게 다루고 내부 문화를 개선하도록 압력을 가하는 결과를 낳았다. 비록 구글이 게브루의 해고에 대해 명확한 입장을 밝히지 않았지만, 사건 이후 연구 논문 검토 절차 변경, 다양성, 형평성, 포용성 목표 이사회 보고 등 내부 변화를 약속하게 만들었다.

게브루가 설립한 분산 인공지능 연구소(DAIR)는 주류 기술 기업의 영향력에서 벗어나 독립적인 환경에서 소외 계층에 초점을 맞춘 윤리적 AI 연구를 수행하는 중요한 모델을 제시했다. 이는 AI 연구가 소수의 엘리트 집단에 의해 주도되는 경향을 비판하고, 기술의 혜택이 사회 전체에 공정하게 분배될 수 있도록 하는 대안적 접근 방식의 가능성을 보여주었다.

또한 그녀는 TESCREAL과 같은 특정 기술 철학에 대한 비판적 시각을 제시하며, 범용 인공지능(AGI) 개발에 대한 맹목적인 추구를 경계하고 기술의 미래에 대한 더 광범위하고 윤리적인 논의를 촉구했다. 게브루의 활동은 AI 분야의 다양성 증진과 사회 정의 실현을 위한 지속적인 노력의 상징으로 남아 있으며, 미래 세대 연구자들에게 기술의 윤리적 함의를 깊이 탐구하도록 영감을 주고 있다.

7. 주요 출판물

- Gebru, Timnit (2017). Visual computational sociology: computer vision methods and challenges. 스탠퍼드 대학교 박사 학위 논문.

- Gebru, Timnit; Krause, Jonathan; Wang, Yilun; Chen, Duyun; Deng, Jia; Aiden, Erez Lieberman; Fei-Fei, Li (2017). "Using deep learning and Google Street View to estimate the demographic makeup of neighborhoods across the United States". 미국 국립과학원 회보, 114(50), 13108-13113.

- Buolamwini, Joy; Gebru, Timnit (2018). "Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification". Proceedings of Machine Learning Research, 81, 1-15.

- Gebru, Timnit (2020). "Race and Gender". In Dubber, Markus D.; Pasquale, Frank; Das, Sunit (Eds.), The Oxford Handbook of Ethics of AI (pp. 251-269). 옥스퍼드 대학교 출판부.

- Gebru, Timnit; Torres, Émile P. (2024). "The TESCREAL bundle: Eugenics and the promise of utopia through artificial general intelligence". 퍼스트 먼데이 (저널), 29(4).

8. 관련 항목

- 코디드 바이어스

- 클레어 스테이플턴

- 메러디스 휘태커

- 소피 장 (내부 고발자)